ChatGPTは簡単に意見を翻す

ChatGPTが登場して以来、私たちはその力に目を奪われてきました。

私たちのどんな質問にも答えてくれるかのようです。

実際、ChatGPTなどの言語モデルに、人間の仕事の一部が奪われる可能性さえ出てきました。

例えば、「歴史や言語、政治、地理などを教える職業は影響を受けやすい」というデータもあります。

他の分野のAIを含めると、将来的に、さらに多くの職業がAIに頼ったり、人間の仕事が奪われたりすると考えられますね。

これほどAIが活躍している理由について、ワン氏は次のように述べています。

「AIが強力なのは、膨大なデータやルールからパターンを発見する能力が人間よりもはるかに優れているからです」

とはいえ、ChatGPTを実際に活用している人たちなら、彼らの述べる情報が「そこまで信頼できない」と感じているはずです。

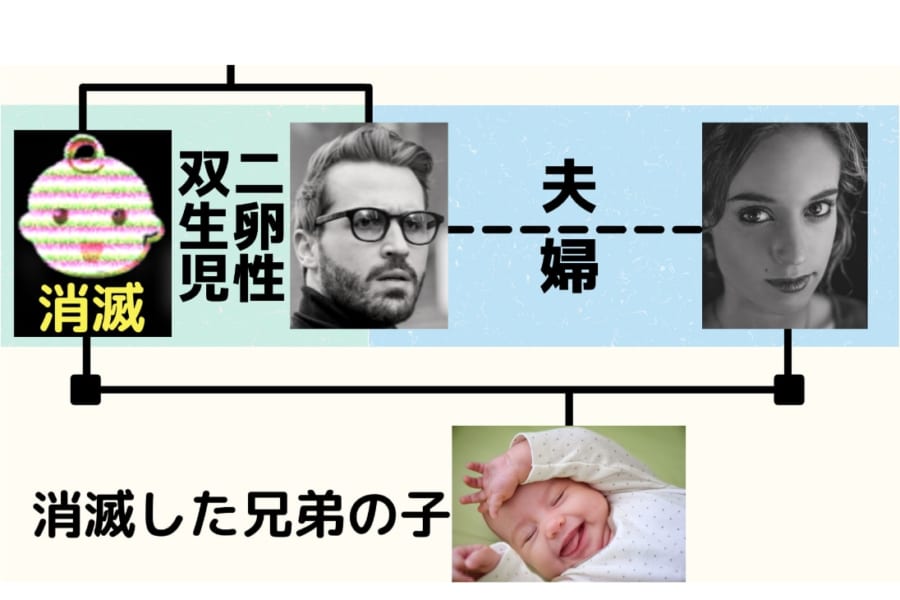

なぜならChatGPTは、自分が提出した回答を簡単に翻すことがあるからです。

私たちがいくらか反論したり、重ねて疑問を投げつけたりすると、彼らはすぐに「申し訳ありませんが、先にお伝えした内容に誤りがありました」と訂正してしまいます。

あまりにも素早く自身の回答を翻すので、ユーザーは「ChatGPTは最初の回答を本当に正しいと感じていたのか?」と疑問を抱きます。

同時に、新しい回答に対する信頼もなくなってしまうでしょう。

ワン氏も、「もし人間が同じことをすれば、人々は、彼が情報をよく理解せずに単なるコピペで話しているだけだと感じるでしょう」と述べています。

では実際のところ、ChatGPTは、情報を正しく理解する能力や、「正しさを貫く」信念を持っていると言えるのでしょうか?

今回、ワン氏ら研究チームは、ChatGPTを使用して現在のAIに信念があるか試してみました。