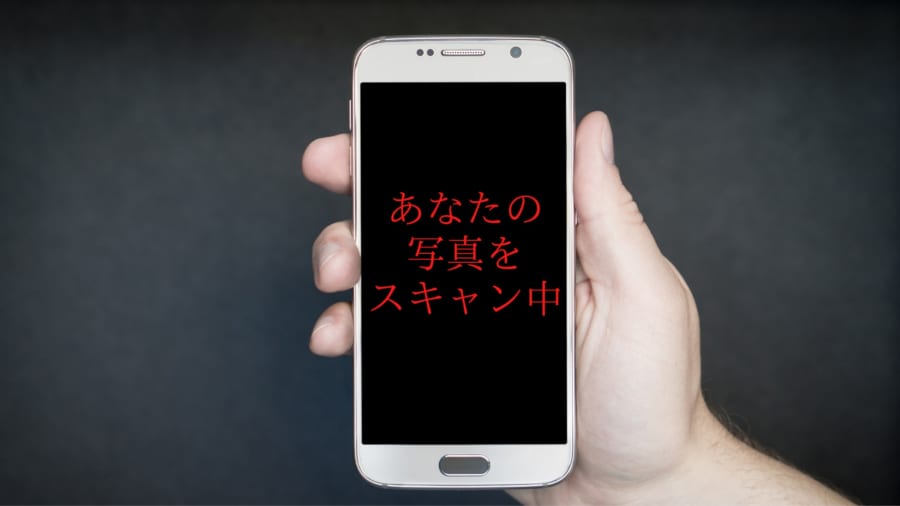

監視ソフトは個人のデータから児童ポルノ画像を勝手にスキャンして通報する

Appleは今年の後半にアメリカで、個人のiPhoneに常駐するタイプの、児童ポルノ検出ソフト「NeuralHash」を導入します。

NeuralHashは数十万にも及ぶ児童ポルノ画像をAIに見せることで学習を行わせ、同じパターンの画像が個人のiCloudにあるかを勝手にスキャンし通報する仕組みをもっています。

またNeuralHashはiPhoneが送受信する画像を監視し、送られてきた児童ポルノ画像をiCloudに入れた場合も、通報が行われることになっているそう。

iPhoneの持ち主が子どもの場合はさらに監視が強くなり、子どもが送受信した画像が児童ポルノだと判断された場合、警告が行われ、さらに子どもが警告を無視すれば両親にも通知されます。

同時に、証拠を押さえるために画像が子どものiPhoneに強制的に保存され、子ども本人が削除不可能になります。

Appleは、このような強力な監視体制を構築するのは全て、児童ポルノを規制するためであると述べています。

そこで今回、コード共有ウェブサイトGitHubのユーザーたちは一足早く、オンラインで公開されているNeuralHashの性能をチェックすることにしました。